이번에 OpenAI사의 ChatGPT를 사용하려다 보니

아래와 같이 다양한 모델이 나오는데,

나같이 ChatGPT의 단순한 기능만 사용하며는 소프트 유저 입장에서는

뭔 말인지 잘 모르겠다는 생각이 들어서

간단히 찾아서 아래와 같이 정리하고

나중에 잊어버리면 다시 찾아보고자 한다. ㅜㅜ

| 특징 | 4o | o1 |

| 모델 사용의 주요 목적 | 다목적 모델 (텍스트 생성, 번역, 요약 등) | 복잡한 추론 및 특수 분야 영역에 사용 |

| 지원하는 포맷 (입력을 받는 포맷) |

텍스트, 이미지, 오디오 등 | 텍스트 전용 |

| 추론 수준 | 일반적인 수준 | 높은 논리적 추론 및 복잡한 문제 해결 가능 |

| 속도 | 상대적으로 빠름 | 상대적으로 느림 |

| 연산 수준 | 상대적으로 낮은 연산 필요 | 더 많은 연산 필요 |

| 출시 시점 | 2024년 5월 | 2024년 9월 |

위와 같은 비교를 통해 보면 아무래도 새로 나온 모델이 더 정확하고 유용하지 않을까 싶어

내가 궁금한 것들은 o1을 통해서 물어보면 되겠다는 생각이 드는데..

지원하는 포맷이 4o가 더 다양하다 보니 그때그때 모델을 선택해서 사용하는 것이 적절할 것 같긴하다.

'컴퓨터 및 인터넷 팁 > AI 활용 Tip & Tool' 카테고리의 다른 글

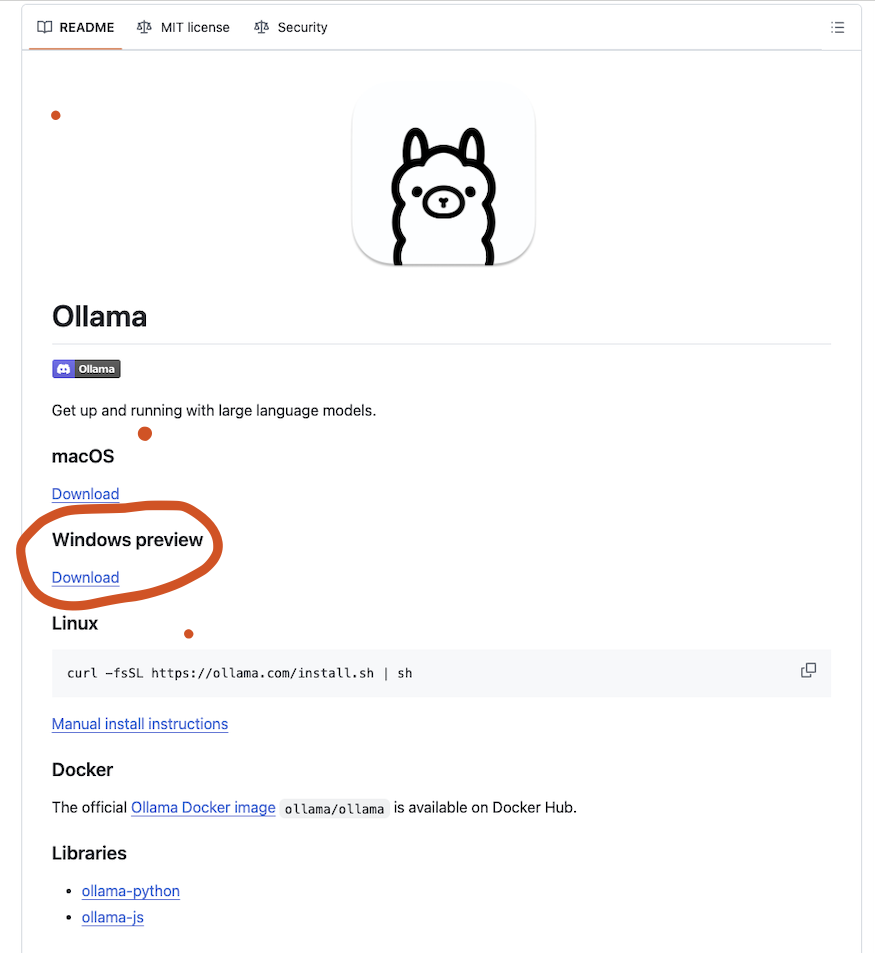

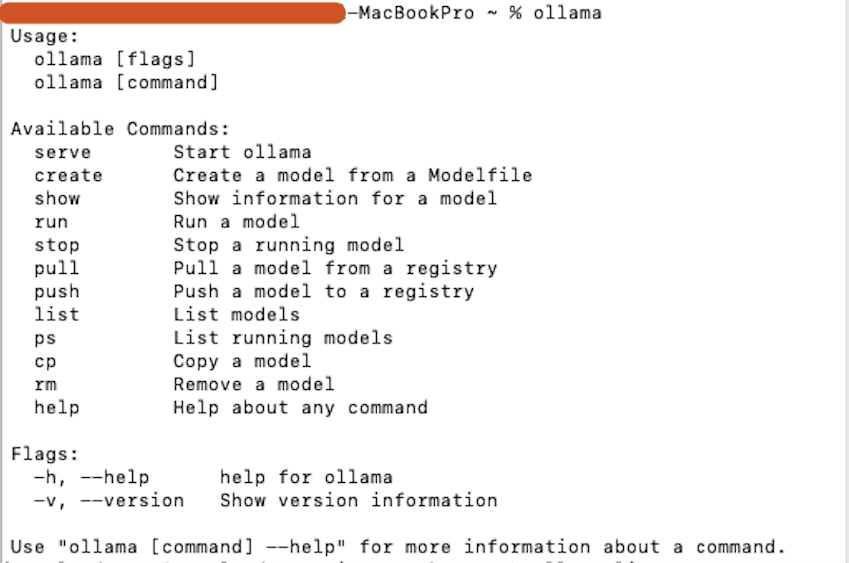

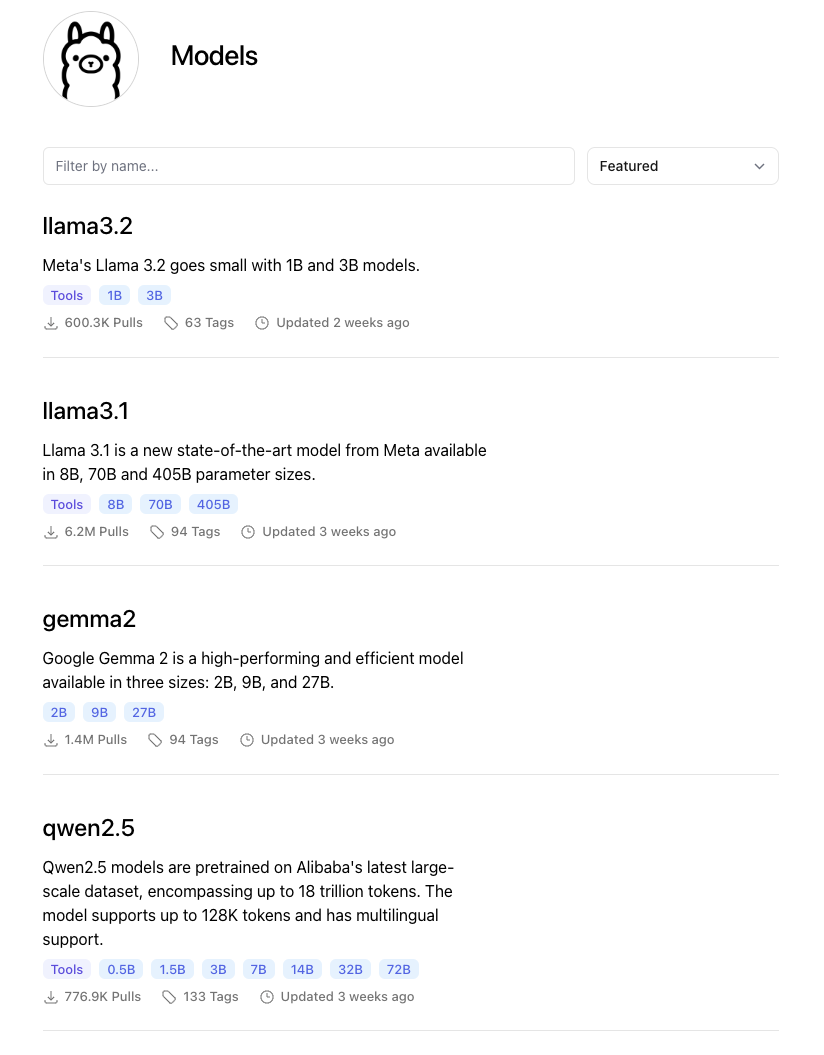

| ollama 를 사용하여 내 개인용 컴퓨터에 AI를 설치해보기 (4) | 2024.10.12 |

|---|---|

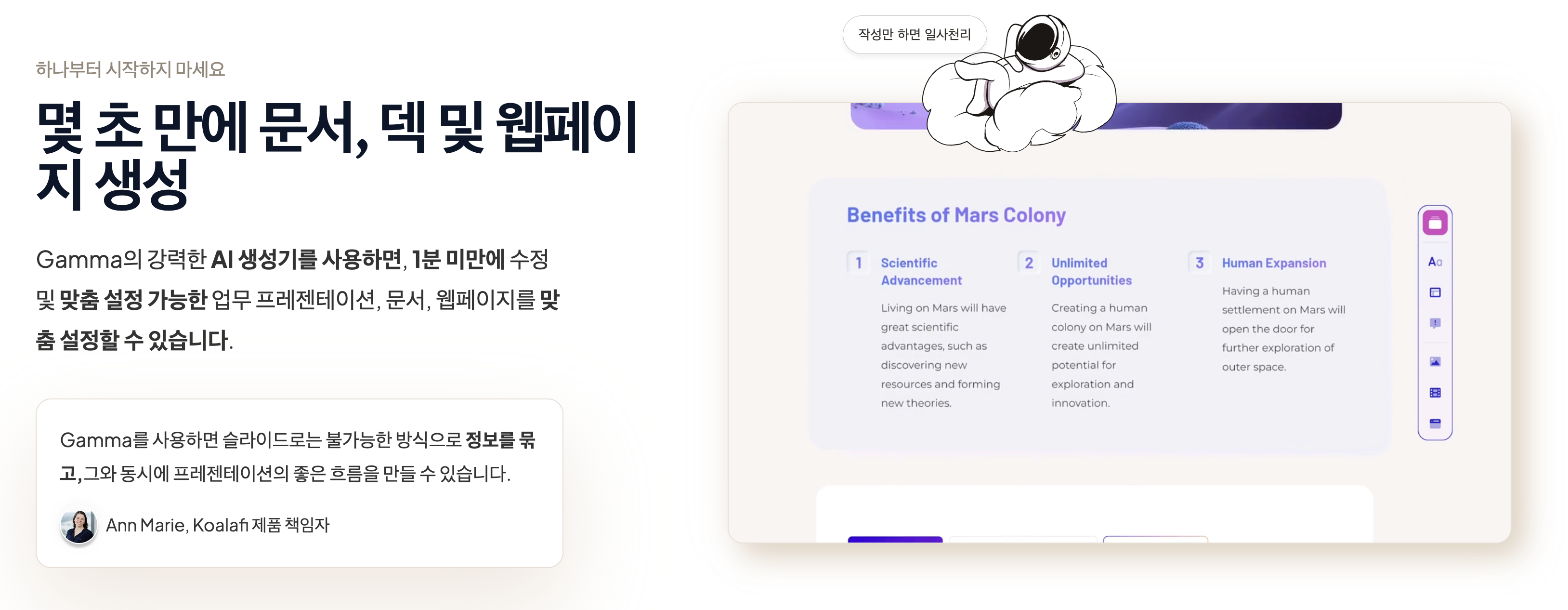

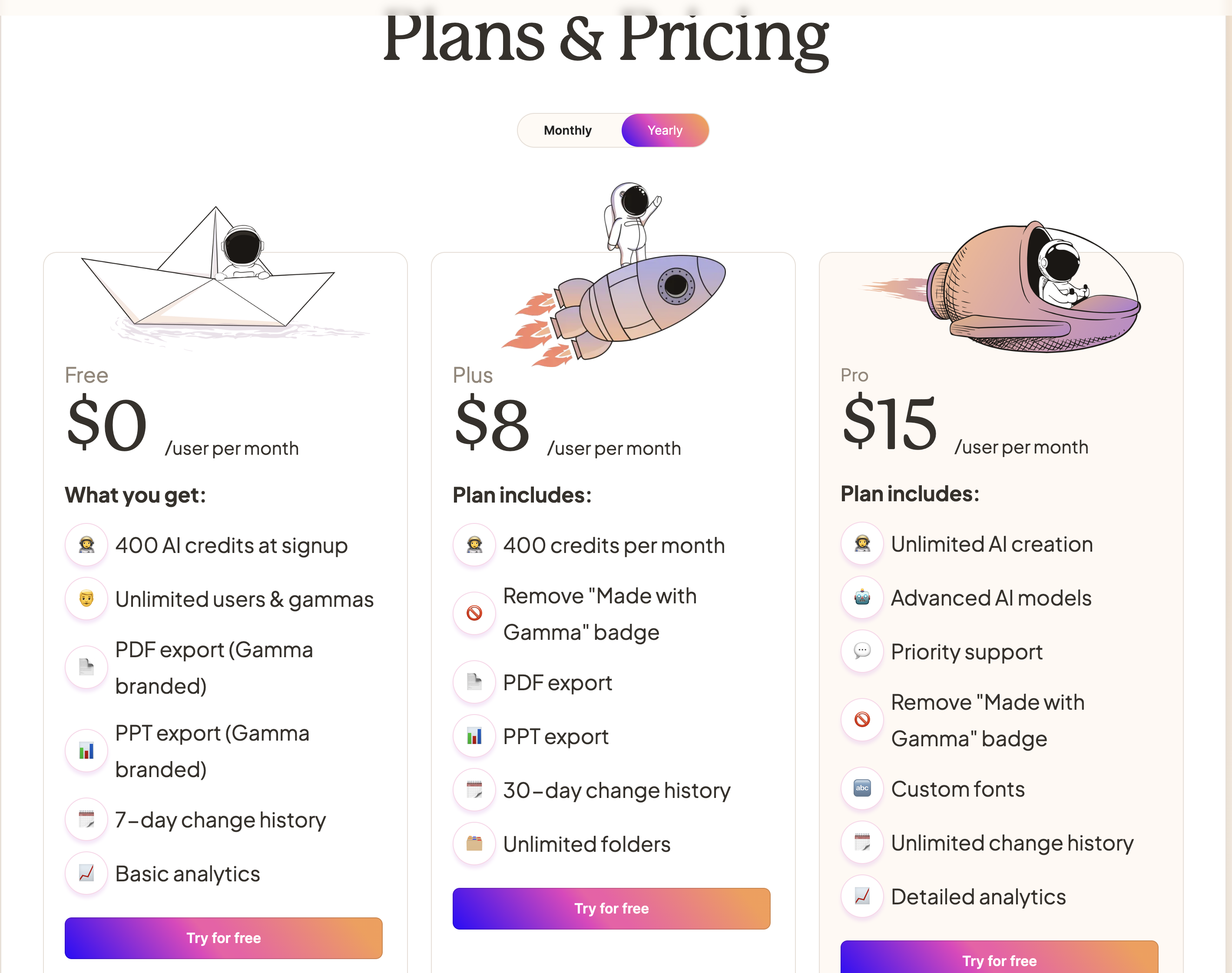

| [AI 툴] Gamma, 초안을 만들어주는 AI 툴 (1) | 2024.02.12 |